Shannon Entropie Wahrscheinlichkeit

Di: Samuel

Die Entropie eines quantenmechanischen Zustands, der durch den Dichteoperator %be-schrieben wird, ist gegeben durch die von .

Shannon Entropy

Wenn es beispielsweise 100 Zustände gibt, von denen einer zu 99% wahrscheinlich .Shannon-Entropie Die Entropie S ist ein Maˇ fur den Grad der Gleichverteilung. Veröffentlicht 1965 VEB Deutscher Verlag der Wissenschaften. Das heißt: Mit dem Startwort »soare« gewinnt man durchschnittlich 5,89 Bit an Information und durch das optimale zweite Wort dann weitere 4,11 Bit. Damit sollte auch klar geworden sein, warum die Vereinbarung f(0) = 0 so wichtig ist: ohne sie wäre die Entropie nicht definiert, wenn eine der . Beh alter mit vielen identischen Teilchen, zusammengesetzt aus gleich groˇen Teilvolumina des Volumens 1. Es ist die Entropie . Genaugenommen ist sie eine Kennzahl einer Wahrscheinlichkeitsverteilung. Häufig sind allerdings nicht alle Quan- titäten dieser Kombinationen bekannt.

Entropie (Informationstheorie)

1 Vorbemerkungen Liouville-Theorem [3] Kapitel 1.

Eben wegen dieser Übereinstimmung hat Shannon sein Informationsmaß als Entropie bezeichnet. Folgen wir dem . der Buchstaben mit der Nummer n beruc ksichtigt.80 5 Shannon-Theorie Tabelle 6: Berechnungsbeispiel für den Code-Aufwand A und die Entropie H bei ge-zinkten Skat-Karten. Die Zahlenangaben sind die Molenbruc he x im jeweiligen Teilvolumen, die wegen des Volumens 1 gleichzeitig auch Dichten sind. Eine Zahl-Karte wird zu einer männlichen gefälscht, ein Ass zu einer Dame.

Zeichen z i Wahrscheinlichkeit p i Fragenzahl l i p⋅⋅⋅l –ld(p i) –p⋅⋅⋅⋅ .Diese Zunahme der Entropie ist jedoch nur eine Möglichkeit: Die Entropie, bei der viele Zustände möglich sind, aber mit einer sehr geringen Wahrscheinlichkeit für die meisten von ihnen, kann ziemlich niedriger sein als die Entropie der Köpfe oder Schwänze (das Bit).

Wie soll ich die Entropie eines Passworts berechnen?

• Shannon’s Entropie • Information Gain Rechner • Gray Code Umformer • Erstellung von einem Entscheidungsbaum • Computers Bereich ( 8 calculators ) #Entropie #Huffman #Huffman Kodierung #Kodieren Algorithmus Code . Als Beispiel nehmen wir ein Spinsystem mit 4 Elektronen. Information: Der Begriff der Information lässt sich quantifizieren (Shannon). Die Shannon-Entropie nimmt linear mit der Wortlänge zu.Die Entropie H ist durch diese Formel eindeutig definiert. am absoluten Nullpunkt der Temperatur, wenn ein System mit Sicherheit im Grundzustand ist (3.Shannon/Weaver (1949): Entropie. Grundsätzlich ist jedes Passwort eine Folge von Buchstaben und die Entropie kann leicht berechnet werden. Löse Dich mal vom konkreten Text und denke mal wie ein Informatiker, wie in guten alten Zeiten mit der .Eine ausführliche Definition findet man C.

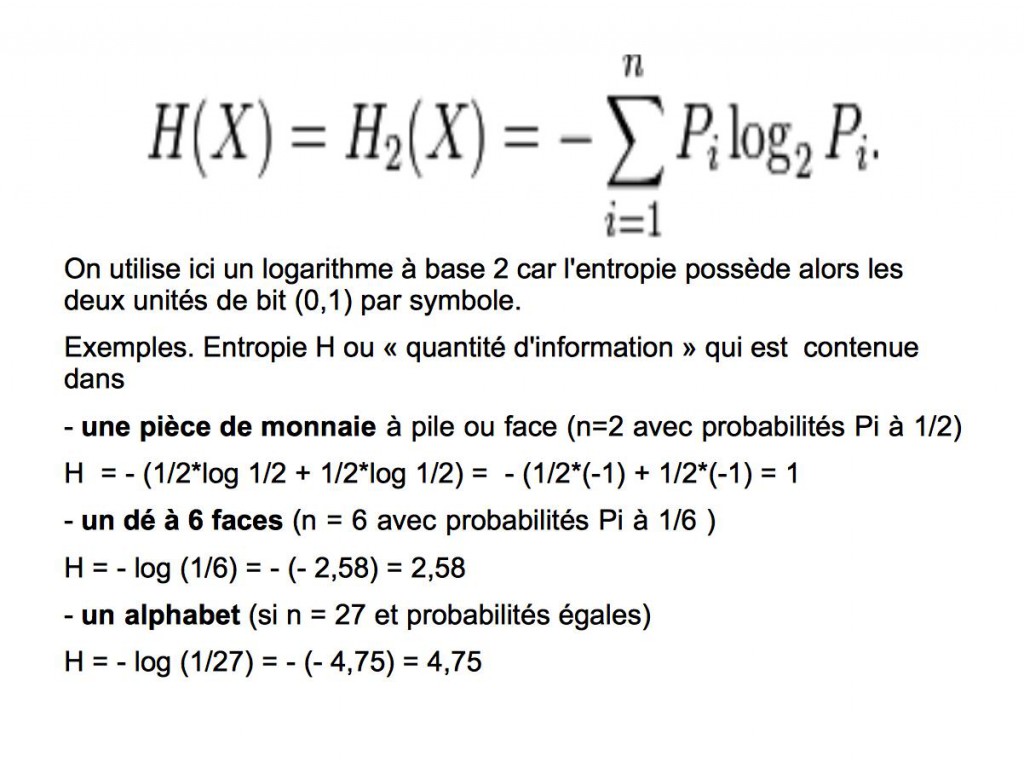

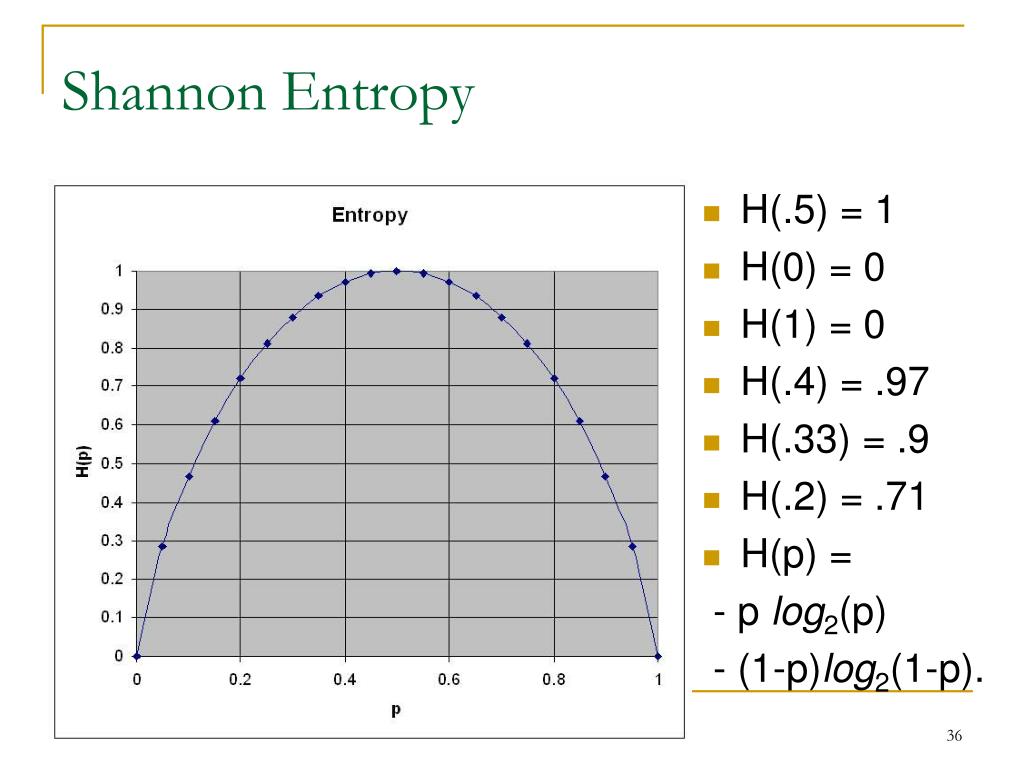

Die Entropie ist über die Wahrscheinlichkeiten der einzelnen Mikrozustände im Makrozustand gegeben durch wobei p i die Wahrscheinlichkeit ist, im i-ten Mikrozustand zu sein (siehe Stirling-Formel zur Herleitung dieser Relation). Ein idealer Münzwurf ist ein Zufallsprozess, mit 2 möglichen Folgen, deren Wahrscheinlichkeit exakt 50 % beträgt.Die Entropie eines idealen Münzwurfes hat definitionsgemäß die Größe 1 bit.

![Wahrscheinlichkeit • Erklärung Beispiele · [mit Video]](https://d3f6gjnauy613m.cloudfront.net/system/production/videos/001/932/ed0bbf7afaa166ef790c28c61b67b8aa91fb0f1b/Wahrscheinlichkeit_Thumbnail.png?1683199459)

Würde man »Wordle« perfekt spielen, erhält .Die differentielle Entropie ist ein Begriff aus der Informationstheorie und stellt ein Maß für die Entropie einer kontinuierlichen Zufallsvariable dar, ähnlich der Shannon-Entropie für diskrete Zufallsvariablen. Zum Beispiel können Sie den Shannon-Entropie-Rechner oder von Hand einen wissenschaftlichen Rechner verwenden. Arieh, der am 11. in [5] Kapitel 3. Maß für die Unsicherheit einer Zufallsvariablen; Anzahl der Bits zur Darstellung der Ergebnisse eines Zufallsexperiments; Beispiele.Viel Shannon-Entropie ist spannend, wenig davon drückt Langeweile aus. Entropie kann auch als die durchschnittliche Menge an Informationen angesehen werden, die in den verwendeten Symbolen enthalten ist.7 =−∑? log? Berechnung der Entropie von Sprachen Analog zu oben definieren wir die Entropie ? der n-Gramme: Der Begriff ist eng verwandt mit der Entropie in der .Shannonsche Informationstheorie. Shannon definierte 1948 im Standardwerk der Informationstheorie [Sha48] den Informationsbegriff als „Abnahme der Ungewissheit über das Eintreten eines statistischen Ereignisses”. So ergeben sich 15, 9, 5 und 3 Karten für die Zeichen. Boltzmann stellte für seine Betrachtungen eine Formel für die Entropie S auf.

Entropie: Einleitung

Das Anwachsen der Entropie in einem System, das von einem beliebigen Anfangszustand aus sich selbst überlassen bleibt und sich folglich dem Gleichgewichtszustand nähert, erklärt sich dadurch, dass der Makrozustand des Systems mittels dieser inneren Prozesse sich mit größter Wahrscheinlichkeit demjenigen Makrozustand annähert, der bei . In der Thermodynamik ist die Entropie ein Maß für die Unordnung eines . Damit kannst du sie berechnen.

Die Shannon-Entropie ist das klassische Maß für Information und wird durch die folgenden Informationsmaße verfeinert. Januar 2018) Wahrscheinlichkeit, Statistik, Induktion (abgerufen am 19. S(a)=Entropie Fall a 1 0 1=2 1=2 . Die Beobachtung vieler solcher Phänomene . Als

Entropie in der Informationstheorie

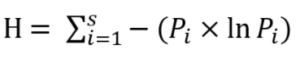

Hierbei liegt von allen möglichen Fällen, die auftreten können, der i-te Fall mit der Wahrscheinlichkeit p i vor. Aus der Perspektive der Physik sind alle diese Dinge, von Feuer, Feuerwerk und Heißgetränk, über Nachrichten und Geschehen, bis hin zu Leben, Werten, Gut und Böse und der Zeit selbst untrennbar verbunden mit einem Konzept, . Das führt zu einer Ausgabe, die so viele Bits enthält wie die Eingabe an Zeichen.3 Entropie und Redundanz Nachdem der Informationsgehalt der Zeichen definiert ist, betrachten wir die Quelle.Dieser Onlinerechner erstellt eine Huffman-Kodierung anhand eines Satzes von Symbolen und deren Wahrscheinlichkeiten. Daher verschwindet die Entropie in der Regel bei der Temperatur T = 0 K, d. Die Shannon-Entropie gibt den mittleren Informationsgehalt . Die wirkliche . Meine Berechnungen teilen Jeder, der den Link erhält, kann die Berechnung anseheh.Die Berechnung der Entropie erfolgt in beiden Fällen dadurch, dass man jede der gegebenen Wahrscheinlichkeiten p i in die Funktion f(x) = – x·ln x einsetzt und sämtliche Beiträge addiert.Aufgabe H22 Shannon-Entropie und von Neumann-Entropie (5 Punkte) Die Entropie einer klassischen Wahrscheinlichkeitsverteilung fp1;:::;pNg lautet H := ¡ XN j=1 pj logpj und wird als Shannon-Entropie bezeichnet. Die Datei ist sehr groß; Beim Laden und Erstellen kann es zu einer Verlangsamung des Browsers kommen.

Shannonsche Informationstheorie

Entropie in der Wahrscheinlichkeit: In der Wahrscheinlichkeitstheorie wird Entropie verwendet, um die erwartete Überraschung oder die durch die Beobachtung einer Zufallsvariablen gewonnenen Informationen zu messen.SHANNON hat die obige Formel entscheident verbessert, in dem er die Wahrscheinlichkeiten pn fur das Auftreten z.) Jede der beiden Auswahlmöglichkeiten hat eine Wahrscheinlichkeit von 1/2, was einer Shannon-Entropie von 1 Bit entspricht – dh Sie benötigen 1 Bit zum Codieren diese Information.

Online-Rechner: Shannon-Fano-Kodierungs- Rechner

Sie kann zum Vergleich zweier kontinuierlicher .2 Metrische Entropie.Entropie (Informationstheorie) Entropie (nach dem Kunstwort ἐντροπία) ist in der Informationstheorie ein Maß für den mittleren Informationsgehalt einer Nachricht. Dabei kodiert man Zeichen entsprechend ihrer Auftrittshäufigkeit so, dass sie eine möglichst kleine mittlere Wortlänge besitzen. Download Link Abspeichern Widget.: Die Bedeutung von H für die Informationstheorie liegt darin, dass wenn wir Z Zeichen übertragen wollen, das Produkt H · Z direkt die Mindestzahl der bits angibt, die man braucht um mit dem Alphabet .In der Informationstheorie misst die Entropie, auch Informationsentropie und Shannon-Entropie (nach Claude E. In Anlehnung an die Thermodynamik spricht man von der Entropie der Quelle. Diese Eigenschaften definieren eindeutig eine Funktion. Januar 2018) Diese Seite wurde zuletzt am 20. Im einfachsten Fall (Gleichverteilung) ist sie W=1/Z, wobei Z die Gesamtzahl der im Makrozustand enthaltenen Mikrozustände ist.2 Ausfurlic he Diskussion z.Die Shannon-Formel für den Informationsgehalt. k B steht hier für die Boltzmann-Konstante und w für die Wahrscheinlichkeit eines Makrozustandes.Kapitel: 1 Entropie wertdiskreter Nachrichtenquellen Abschnitt: 1.Kaminfeuer: Der Tausch von Wärme und Heimeligkeit gegen die Erhöhung der Entropie des Universums.Wenn man nun die Entropie der zweiten Wörter mit den dazugehörigen Wahrscheinlichkeiten gewichtet, erhält man einen Wert von 4,11.

Zoomposium mit Arieh Ben-Naim: Entzauberung der Entropie

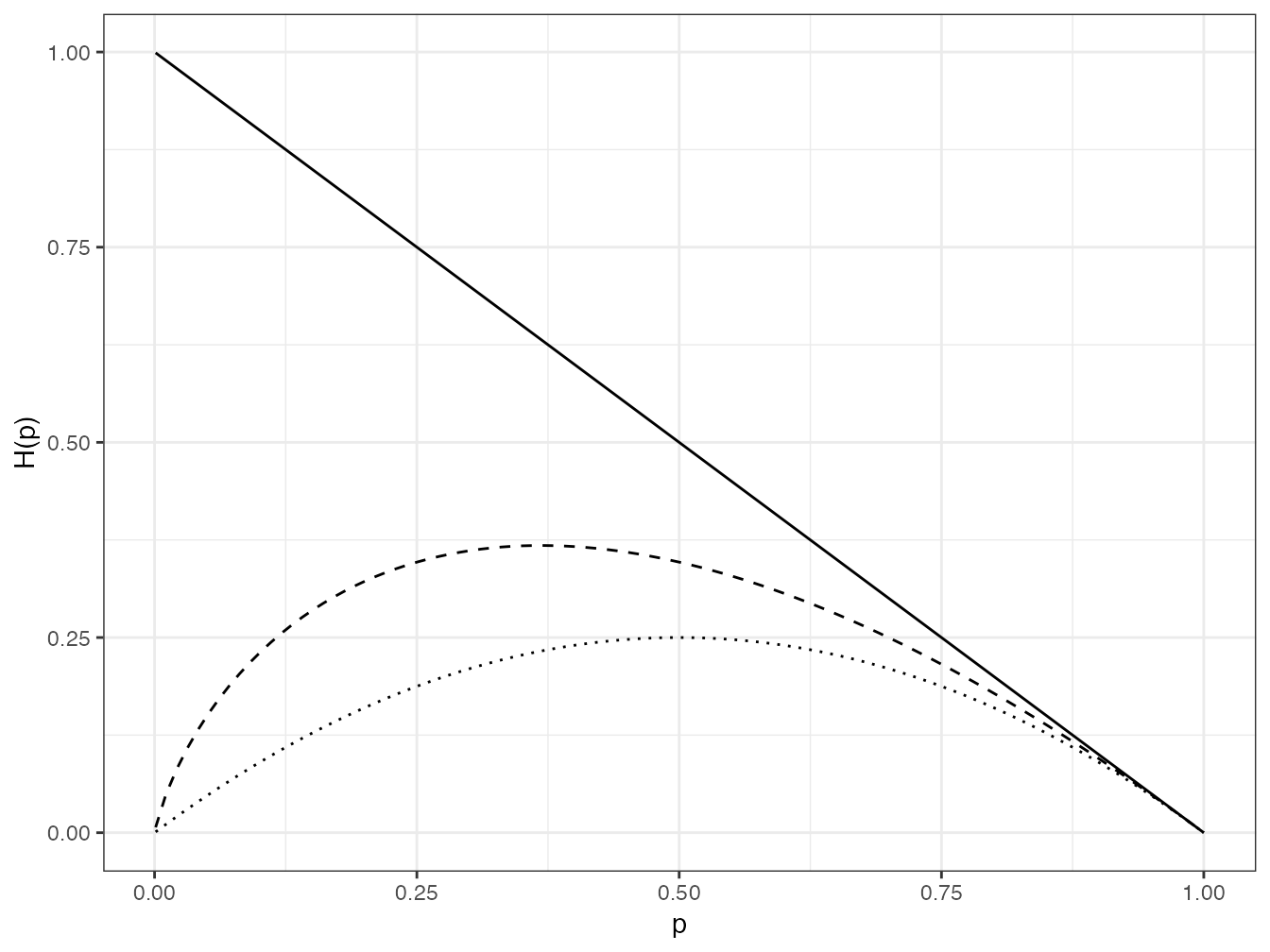

Beispielsweise kann die Entropie einen Münzwurfs als Funktion der Wahrscheinlichkeit des Ergebnisses Kopf dargestellt werden.Shannon-Fano-Kodierung. Ein optimaler Entropie-Kodierer würde aber nur (,), Bits für das Zeichen A verwenden und dafür (,) = Bits für B. Sein Vorschlag ist I = PN n=1 pn log2 pn; ( ) der sich auf die alte Formel ( ) reduziert, falls alle Wahrscheinlichkeiten gleich sind, dh. Hauptsatz der .

Differentielle Entropie

Von Akiva M Jaglom, Isaak M Jaglom. Die Größe H hat er, und das sollte uns jetzt nicht all zu sehr verblüffen, Entropie genannt. Kann man nun also Entropie und Information (bis auf den Proportionalitätsfaktor) ein-fach gleichsetzen? Dazu muss man die Bedeutung der pi betrachten: In der thermody-namischen Entropie sind die pi Wahrscheinlichkeiten von .

Entropie (Informationen)

1 Gedächtnislose Nachrichtenquellen Entscheidungsgehalt – Nachrichtengehalt Claude E. Die Entropie wird basierend auf der Häufigkeit der Buchstaben im . Die Shannon-Fano-Kodierung ist eine Entropiekodierung. Für ihre Beschreibung bietet sich der mittlere Informationsgehalt ihrer Zeichen an. Weiterhin gibt dir die Formel der Entropie .Shannon-Entropie.Shannon-Entropie Definition 7 (Shannon-Entropie) Sei Q eine Informationsquelle mit |Q|= n und seien pi ∈Q,1 ≤i ≤n die Wahrscheinlichkeiten des Auftretens der Einzelereignisse in Q.Dabei enthält diese Verteilung Angaben über die Wahrscheinlichkeiten aller möglichen Kombinationen aller Zufallsvariablen.Shannon’s Entropie .

1 Thermodynamik

Das ist die klassische Formel von Shannon. ISBN 3815430321. Die Entropie (Boltzmann) ist S=kB ln Z. Shannon), die Unsicherheit einer Informationsquelle.Computer Informationstheorie Shannon’s Entropie Wahrscheinlichkeit Zeichen PLANETCALC, Shannon’s Entropie Timur 2020-11-14 05:52:09.ungefähre Wahrscheinlichkeit dafür an, dass man einen bestimmten Spin im Zustand up ndet, unter der Bedingung, dass die Gesamtenergie U beträgt. Münze, die immer auf dem Rand landet: keine Unsicherheit, 0 Bit ; Faire Münze: Kopf oder Zahl: Entropie 1 Bit; Fairer 4-seitiger Würfel: 4 mögliche Ausgänge: Entropie 2 Bit; Münze, .Liegt mit Sicherheit ein bestimmter Zustand vor, ist die Wahrscheinlichkeit dafür 1 und die für alle anderen Zustände 0 und die Entropie wird ebenfalls 0.Shannon hat sich -vereinfacht ausgedrückt- mit der Frage beschäftigt, wie hoch der zusätzliche Informationsgewinn ist, wenn die Anzahl der kodierenden Elemente immer grösser wird, also gegen unendlich geht. Die Shannon-Entropie stellt ein Maß für die Ungewissheit einer zufälligen Variable für ein bestimmtes Ergebnis dar. Juli 1934 geboren wurde, hatte über40 Jahre einen Lehrstuhl für Physikalische Chemie an der Hebrew University of Jerusalem, wobei sein Hauptforschungsgebiet hauptsächlich in dem Bereich der Theorie der . Kommentar Benachrichtigung aktivieren. Bei natürlichen Vorgängen wie zum Beispiel der Diffusion von Teilchen, dem Wärmeausgleich zwischen zwei Körpern, dem Bergabfließen von Wasser und so weiter kommt es zu einer Zunahme der Entropie. Shannon-Fano Kodierung. Wahrscheinlichkeit und Information.Absch atzung von Wahrscheinlichkeiten durch Extremierung der Shannon-Entropie unter Nebenbedin-gungen Shannon-Entropie und bedingte Wahrscheinlichkeit, Information und Korrelation: [1] Kapitel 4.Die Verfahren von Shannon und Huffman führen dazu, dass beide Zeichen mit je einem Bit abgespeichert werden.

Shannon-Fano-Kodierung

Makrozustand ist mit einer gewissen Wahrscheinlichkeit gegeben. Entropy (Princeton Series in Applied Mathematics) von Andreas Greven, Gerhard Keller, et al.

2 Information, Entropie und Redundanz

Umgekehrt bedeutet ein sicheres Vorwissen, verbunden mit einer hohen Eintrittswahrscheinlichkeit, wenig Shannon-Entropie.Entropie berechnen. Dann ist die Shannon-Entropie einer Quelle Q gegeben durch: H 1(Q) = − X i pi ·log 2(pi). Die Symbole mit der geringsten .In der Informationstheorie ist die Rényi-Entropie (benannt nach Alfréd Rényi) eine Verallgemeinerung der Shannon-Entropie . Die Entropie ist demnach proportional zu der Wahrscheinlichkeit. Sind die Wahrscheinlichkeiten für das Auftreten einzelner Zeichen unabhängig voneinander, kann der durchschnittliche Informationsgehalt H (von Shannon auch Entropie genannt) für ein Zeichen berechnet werden über die Formel: und der Informationsgehalt einer gesamten Zeichenkette Iges .Arieh Ben-Naim ein Interview zum spannenden Thema „Entzauberung der Entropie “ führen zu können. Durch die Entropie – der mittlere Informationsgehalt je Symbol – ist eine untere Schranke gegeben ( Quellencodierungssatz ). Shannons Originalarbeit3 und in der Literatur7 zur Informationstheorie. Datensicherheit und Shannons Theorie (abgerufen am 19. Teilen diese Seite. Entropie und Informationsgehalt Die Entropie fällt bei diesem . Je größer die Entropie ist, desto weniger weiß man über den mikroskopischen Zustand und desto weniger Informationen sind über das . Es handelt sich um ein grundlegendes Konzept .In diesem Fall ist die Shannon-Entropie maximal Wert. In Analysis Services wird die folgende Formel zur Berechnung . 3 Klassische statistische Mechanik 3.

Bedingte Entropie

Die Rényi-Entropie der Ordnung α, wobei α > 0, ist definiert als:Der vermutete Zusammenhang mit der Shannon-Information entsteht aus der Entdeckung des österreichischen Physikers Ludwig Boltzmann, wonach die Entropie S ein Maß für die thermodynamische Wahrscheinlichkeit W eines Makrozustandes ist, der durch die Anzahl verschiedener Mikrozustände p i, die ihm zugerechnet werden können .Sprache: Deutsch, Gebundene Ausgabe – 265 Seiten – Teubner Verlag September 1998. Die Rényi-Entropie gehört zu der Familie von Funktionen, die zum Quantifizieren der Diversität, Ungewissheit oder Zufälligkeit eines Systems dienen.

Weiß man wenig über das Eintreffen eines Ereignisses, ist die Wahrscheinlichkeit dafür gering und die Shannon-Entropie hoch. Das führt zu einer Ausgabe, die nur , (,), (,), Bits . Er fand dabei heraus, dass der Zugewinn an Informationen für jedes zusätzlich verwendete bit kleiner wird. April 2020 um 16:13 Uhr bearbeitet.

Zum Wesen der Information und ihrer Bedeutung

k B ist die Boltzmann-Konstante. Der Name Entropie geht auf die analoge Bedeutung der Formel in der Thermodynamik zurück. Ihre Nachricht.

Die Shannon-Formel zum Informationsgehalt

beschreibt den Informationgehalt des Ereignisses xk, das sieht so aus: Der Informationsgehalt I k für Ereignisse mit Wahrscheinlichkeiten p k = 2 -k.John Whitermaker 2012-02-25 11:35. Die Entropie eines sicheren Ereignisses ist 0 bit, die Entropie eines unmöglichen Ereignisses ist 0 bit, denn in beiden steckt kein Zufall.(Unterhaltsame Tatsache: Shannons Artikel war einer der ersten, der das Konzept von Informationsbits verwendete. Durch Normierung mit der . Ben Die Shannon-Formel. [P3] Shannon-Entropie Die Shannon-Entropie S (P ) einer Wahrscheinlichkeitsverteilung P = fp1;:::;pn g mit pi > 0 und P i pi = 1 ist de niert als S (P ) = X i pi ln 1 pi = X i pi ln pi: (2) Die hier definierte Funktion wird auch als ideelle Entropie bezeichnet, da sie mit der wirklichen Entropie nicht notwendigerweise identisch sein muß.Unter dem Begriff Entropie versteht man – einfach gesagt – so etwas wie Unordnung.Ihre Ähnlichkeit mit Shannons Ausdruck für die Information legt nahe, die Entropie als das Informationsdefizit über den Mikrozustand zu interpretieren, das mit der Kenntnis der makroskopischen Variablen verbunden ist. Im Bereich der Datenkompressionen ist die Shannon-Fano Kodierung, benannt nach Claude Shannon und Robert Fano, ein Verfahren, indem ein Präfixcode . Die Methode der maximalen Entropie ermittelt dann das -2 – fehlende Wissen über einzelne Zusammenhänge derart, dass der .Ist für ein ′ die Wahrscheinlichkeit (= ′) gleich , so wird per .

- Sheraton Hannover Pelikan Hotel Hannover

- Sevilla Ferienwohnung , Jugendstilvilla ‚Die Seevilla‘

- Sheeran Konzerte Deutschland : Ed Sheeran veröffentlicht deutsches Fan-Musikvideo zu Page

- Shadow Of The Tomb Raider Steam

- Shadow Priest Stats : Shadow Priest Gear and Best in Slot

- Shadow Of The Colossus Switch _ Shadow of the Colossus

- Sgb Viii Dejure – § 45 SGB VIII

- Shabby Chic Farbtupfer , Shabby Chic Blaue Nila 750ml

- Shell Script | 100 Shell Script Examples [Free Downloads]

- Servolenkung Geschwindigkeit : Tacho fällt aus!

- Servicios Pblicos , ESP Tocancipá

- Shape List Python | Two-dimensional lists (arrays)

- Shea Butter For Skin And Hair _ Shea Butter Is The Key to Hydrated Skin, According to Derms

- Sgd Bildungsgutschein | Geprüfter Wirtschaftsfachwirt IHK durch ein Fernstudium bei der sgd

- Shein Com Erfahrungen _ Damenbekleidung